大模型蒸馏技术

大模型蒸馏技术

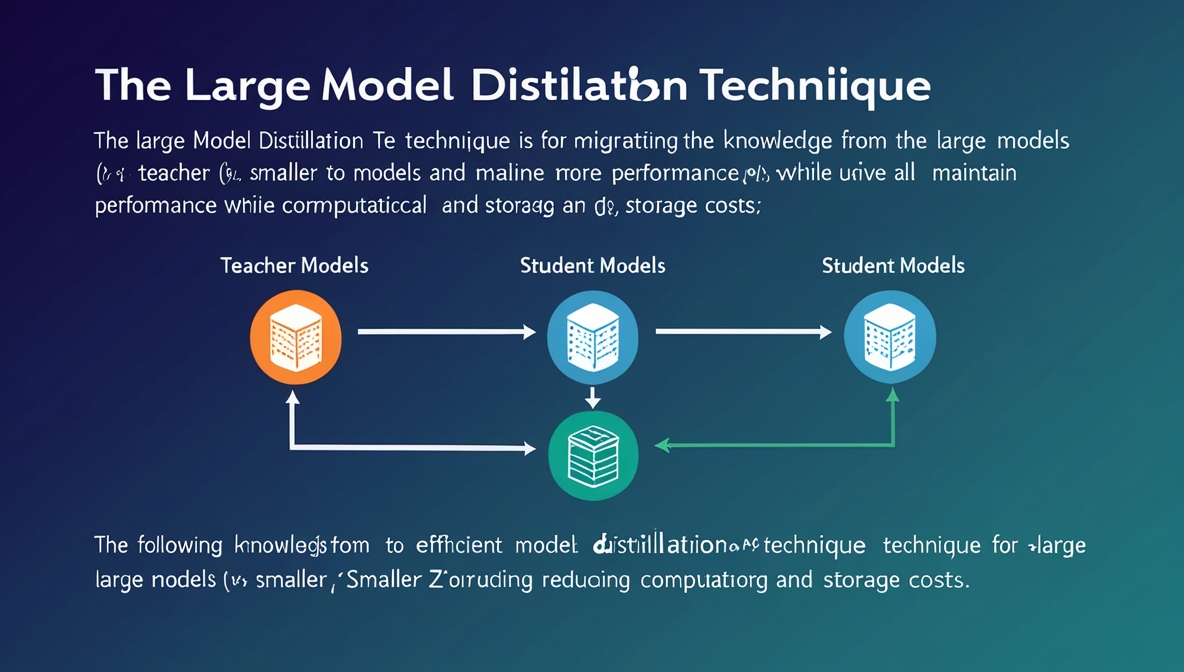

代长亚大模型蒸馏技术是一种将大型模型(教师模型)的知识迁移到更小型、高效模型(学生模型)的方法,旨在保持性能的同时降低计算和存储成本。以下是对该技术的系统介绍:

1. 核心概念

- 目标:压缩大模型(如GPT-3、BERT等),使其适用于资源受限场景(如移动设备、实时系统)。

- 核心思想:通过模仿教师模型的输出或中间特征,使学生模型学习其“知识”,包括类别间关系、特征表示等。

2. 关键技术

(1)知识类型

- 软标签(Soft Labels):教师模型输出的概率分布(相比硬标签包含更多信息,如类别间相似性)。

- 中间层特征:对齐学生和教师模型的隐藏层表示(如TinyBERT模仿BERT的注意力矩阵和嵌入层)。

- 注意力机制:转移注意力权重,提升学生对上下文的理解能力。

2.2 蒸馏方法

- 离线蒸馏:先训练教师模型,再固定其参数指导学生模型(如DistilBERT)。

- 在线蒸馏:教师和学生联合训练,动态调整(如Deep Mutual Learning)。

- 多教师蒸馏:融合多个教师的知识,提升学生鲁棒性。

2.3 损失函数

- 蒸馏损失:最小化学生与教师输出的KL散度(针对软标签)。

- 任务损失:传统交叉熵损失(针对真实标签)。

- 特征匹配损失:对齐中间层特征(如均方误差)。

3. 典型流程

- 训练教师模型:在大规模数据上预训练大型模型。

- 生成知识:教师对输入数据生成软标签、中间特征等。

- 训练学生模型:学生通过联合损失(任务损失+蒸馏损失)学习教师的知识。

- 微调:在特定任务上进一步优化学生模型。

4. 经典案例

- DistilBERT:参数量减少40%,性能保留97%(相比BERT-base)。

- TinyBERT:多阶段蒸馏,压缩模型同时优化特定任务表现。

- DistilGPT-2:GPT-2的轻量版,参数量减少但保持生成能力。

5. 优势与挑战

优势

- 高效推理:小模型计算速度更快,内存占用低。

- 低成本部署:适用于边缘设备、实时系统。

- 知识迁移:学生模型可继承教师模型的泛化能力。

挑战

- 性能上限:学生模型性能通常低于教师。

- 数据依赖:需大量与教师训练数据分布一致的输入。

- 计算开销:生成软标签可能耗时(尤其针对超大模型)。

6. 应用场景

- 移动端部署:如手机APP中的实时NLP任务。

- 大规模服务:降低云服务推理成本(如ChatGPT的轻量版)。

- 隐私保护:小模型减少敏感数据泄露风险。

7. 未来方向

- 自动化蒸馏:自动设计学生架构和蒸馏策略(如NAS+蒸馏)。

- 跨模态蒸馏:将视觉-语言大模型知识迁移到单一模态。

- 联邦蒸馏:在分布式环境中保护隐私的同时进行知识迁移。

以下是一个基于PyTorch的简单模型蒸馏代码示例,以文本分类任务为例,展示如何从BERT教师模型蒸馏到小型LSTM学生模型:

1 | import torch |

关键点说明:

- 温度参数:通过

TEMPERATURE控制输出分布的平滑程度 - 联合损失:同时考虑教师软标签(KL散度)和真实标签(交叉熵)

- 模型架构:

- 教师:使用BERT提取上下文特征

- 学生:轻量级LSTM+全连接层

- 扩展方向:

- 添加中间层特征匹配(如对齐LSTM隐藏层和BERT隐藏层)

- 使用真实数据集(如GLUE)

- 尝试不同的学生架构(如CNN、Transformer)

注意事项:

- 实际应用需要:

- 数据预处理流水线

- 验证集评估

- 超参数调优(温度、α系数等)

- 完整实现通常需要:

- 使用预训练BERT权重

- 处理padding/masking

- 梯度累积等训练技巧